EIN

KOMPAKTER ÜBERBLICK

Dieser Überblick beschäftigt sich mit Sensoren, die nicht punktuell an einer einzelnen Messstelle erfassen. Sie nehmen vielmehr ein zwei- bzw. dreidimensionales Abbild der Umgebung auf. Die Rede ist von Wärmebildsensoren, von Kameramodulen und von sog. LIDAR-Systemen zur laserbasierten dreidimensionalen Abtastung der Umgebung. Diese Sensoren werden i.d.R. mit einer leistungsfähigen, bildverarbeitenden Algorithmik kombiniert, die eine Vielzahl interessanter Anwendungen wie Objekt- und Personenerkennung oder autonomes Fahren ermöglicht.

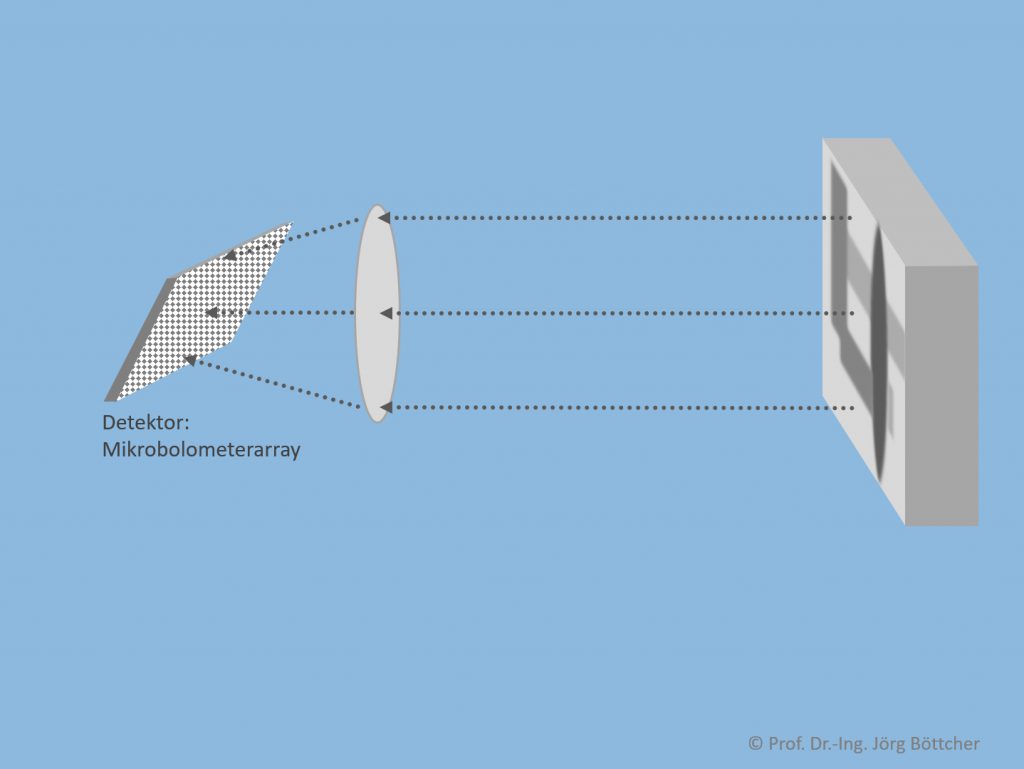

Wärmebildsensor

Seit längerem werden z.B. zur Aufnahme von Wärmebildern im industriellen Umfeld oder an Hausfassaden mehr oder weniger großvolumige Wärmbildkameras eingesetzt. In den letzten wenigen Jahren wurden nun kleinvolumige Sensoren eingeführt, die Wärmebilder mit Auflösungen von z.B. 640 × 512 Pixel (um auf einen weit verbreiteten Typ zu referenzieren) und Messzeiten von deutlich unter einer Sekunde pro Bild erzeugen. Diese können über konventionelle Videoausgänge oder über eine Digitalschnittstelle ausgelesen werden. Es werden sowohl reine Sensorchips als auch komplette Miniatursensormodule mit integrierter Optik in verschiedensten Brennweiten angeboten.

Prinzip eines Wärmebildsensors

Die bildaufnehmende Struktur ist ein in Pixel unterteiltes Flächenelement. Jedes Pixel wertet die durch die einfallende Strahlung generierte Erwärmung aus (sog. Bolometerprinzip). Bei diesem Detektorchip ist eine die eigentliche Infrarotstrahlung aufnehmende Membran aus typischerweise Vanadiumoxid (VOx) bzw. amorphem Silizium (a-Si) wärmeisoliert über einer darunterliegenden Ausleseelektronik aufgehängt. Die Aufhängung erfolgt über zwei Stäbe, die gleichzeitig als Elektroden dienen. Über diese Elektroden wird der elektrische Widerstand der Membran gemessen, der sich bei Erwärmung ändert.

Entsprechende Chips bzw. damit aufgebaute Sensormodule sind für unterschiedliche Wellenlängen im nahen bzw. mittleren Infrarotbereich erhältlich.

Bei Anwendungen mit Wärmebildsensoren ist im Gegensatz zur Einzelpunktmessung mit Pyrometern meist mehr die flächige Temperaturverteilung von Interesse und nicht so sehr der genaue Temperaturmesswert an einzelnen Stellen. Um letzteres einigermaßen exakt zu messen, ist eine Kalibrierung anhand einer spezifischen Messoberfläche vorzunehmen.

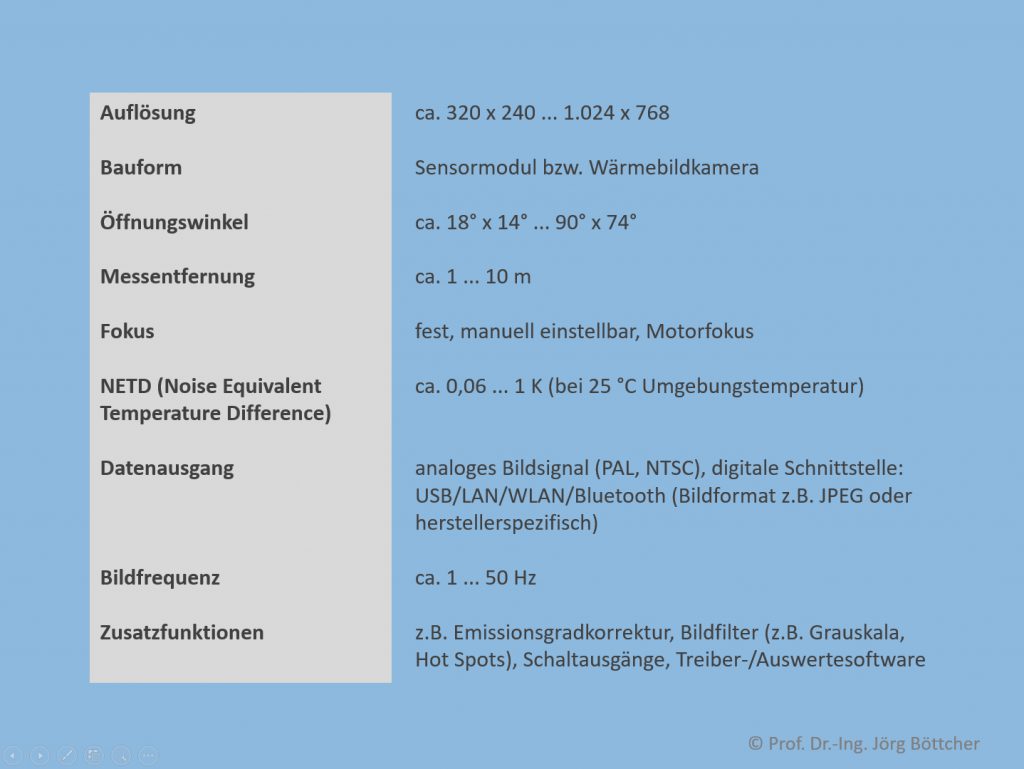

Kenndaten von Wärmebildsensoren

Heute verfügbare Wärmebildsensoren sind typ. mit folgenden Kenndaten ausgestattet:

Kenndaten von Wärmebildsensoren

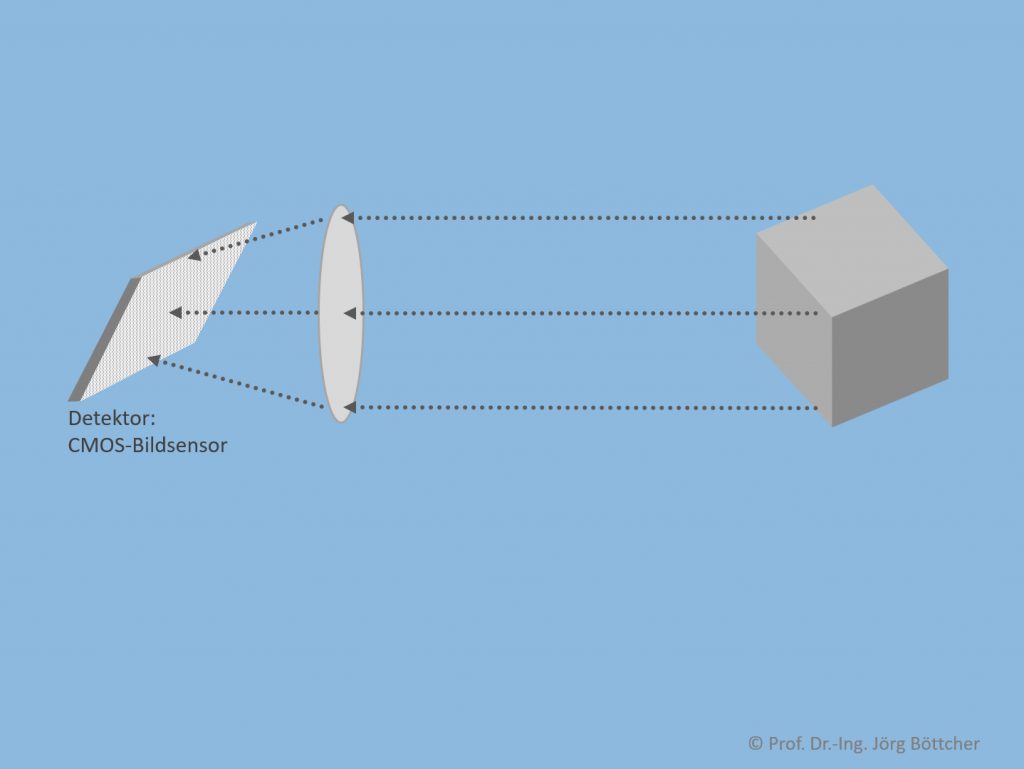

Kameramodul

Herkömmliche Bilder im sichtbaren Spektralbereich können (außer natürlich mit herkömmlichen Kameras bzw. Smartphones) mit kompakten Kameramodulen erfasst werden und über ähnliche Anschlüsse wie bei Wärmebildsensoren nachgeschalteten Auswerterechnern zugeführt werden. Als Detektor werden heute fast ausschließlich die aus der Welt der Digitalkameras bekannten CMOS-Bildsensoren (Complementary Metal-Oxide Semiconductor) eingesetzt.

Prinzip eines Kameramoduls

Beim CMOS-Bildsensorchip besitzt jedes Pixel eine Photodiode. Vor einer Belichtung werden alle Photodioden eines Sensorchips an eine Referenzspannung gelegt, welche in den jeweiligen Sperrschichtkapazitäten gespeichert wird. In Abhängigkeit von Lichtstärke am jeweiligen Pixel und Belichtungszeit werden die Kapazitäten dann durch einen mehr oder weniger großen, durch die Belichtung generierten Photostrom entladen. Nach der Belichtungsphase werden sämtliche Kapazitäten durch sequentielles Ansteuern innerhalb einer Matrixstruktur mit Zeilen und Spalten nacheinander ausgelesen und über einen schnellen Analog-Digital-Umsetzer (ADU) bzgl. ihrer Spannung digitalisiert. Eine verbreitete Bezeichung für Sensorchips mit derart aktiv angesteuerten Pixeldioden lautet „Active Pixel Sensor“ (APS).

Photodioden können zunächst nur Helligkeitswerte und keine Farben detektieren. Um auch die Farbinformationen zu erhalten, werden die Sensorchips in der am weitesten verbreiteten Bauform mit einer Filterschicht überzogen, die waben- oder schachbrettförmig jeder Photodiode einen Farbfilter für eine der drei RGB-Grundfarben Rot, Grün oder Blau vorschaltet (sog. Mosaikfilter). Pro Pixel wird also nur ein Grundfarbwert detektiert. Mit einem speziellen Algorithmus wird in der nachgeschalteten Elektronik über einen sehr schnellen Signalprozessor dann per Interpolation aus den Farbwerten benachbarter Pixel jedem einzelnen Pixel eine komplette Farbinformation wieder zugeordnet.

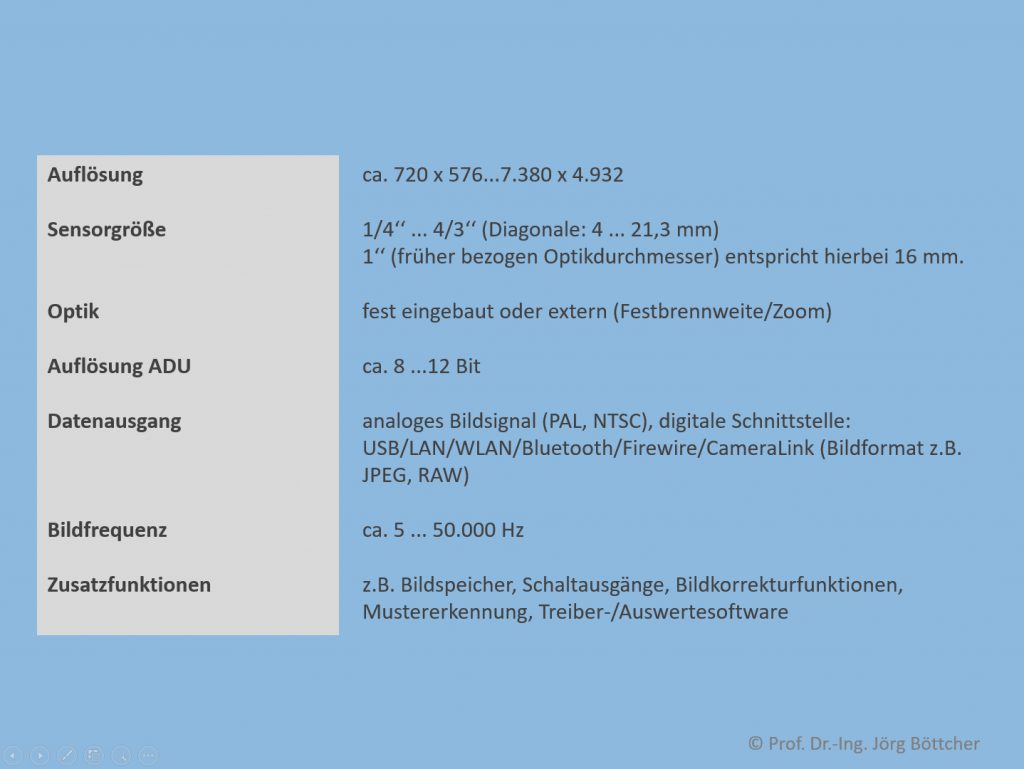

Kenndaten von Kameramodulen

Auch bei Kameramodulen wollen wir die für die am Markt erhältlichen Typen bestehenden Kenndaten im Überblick betrachten:

Kenndaten von Kameramodulen

LIDAR-Sensor

In jüngster Zeit kommen verstärkt sensortypisch miniaturisierte Ausführungen von Messeinrichtungen auf den Markt, die die Umgebung mit einem Laserstrahl sehr schnell abtasten und dadurch ein dreidimensionales Abbild gewinnen. Das zugrundeliegende LIDAR-Verfahren steht für Light Detection and Ranging.

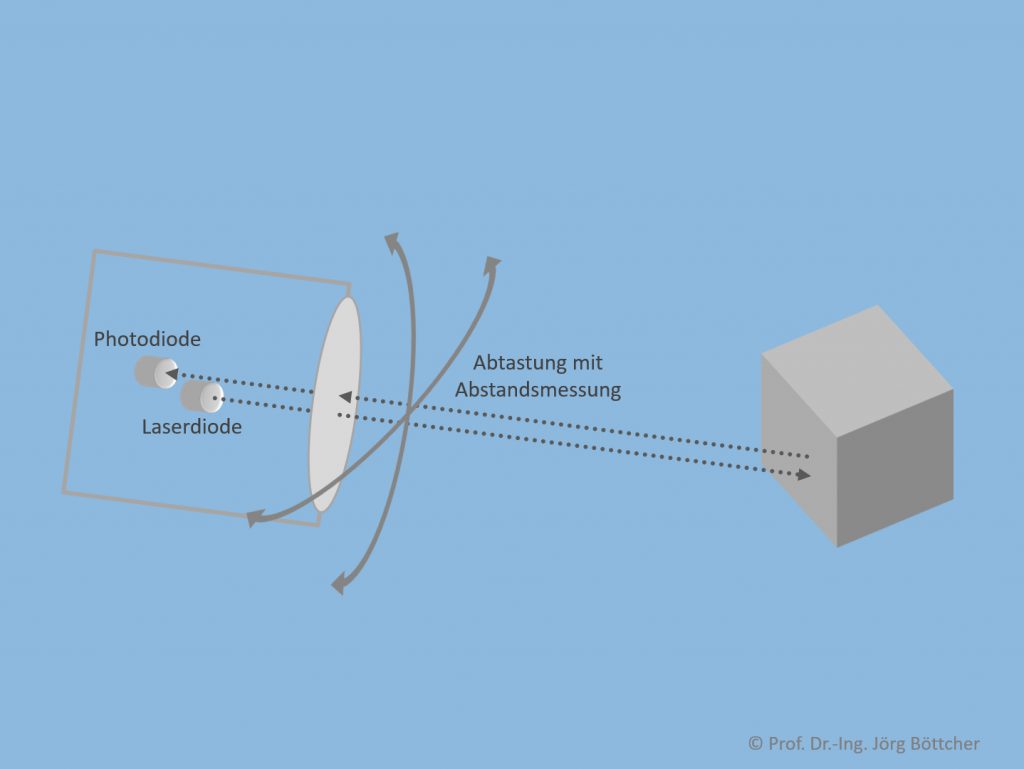

LIDAR-Prinzip

Ein Laserstrahl tastet in schneller Sequenz einen Raumbereich ab, indem die Lasereinheit selbst oder eine davor angebrachte Spiegelanordnung in zwei Raumrichtungen systematisch abgelenkt wird. Alternativ sind auch z.B. rotierende Anordnungen denkbar, wie sie bevorzugt bei Rundumsichtsystemen zum Einsatz kommen. Mit einer gewissen Auflösung wird dann pro neuer Laserstrahlposition dessen Laufzeit gemessen, wodurch der Abstand vom LIDAR-Sensor zum abgetasteten Oberflächenpunkt bestimmt werden kann. In einem entsprechenden Dateiformat wird jedem „Raumpixel“ ein Abstandswert zugeordnet. Das Ergebnis ist also ein dreidimensionales Bild aus der Perspektive des Sensors.

WENN SIE ES GENAUER WISSEN WOLLEN: